Convolutional Neural Networks - Hinter den Kulissen

Spezialkurs zu Convolutional Neural Networks und Residual Nets - Deep Learning Architekturen für die Bildverarbeitung

4.67 (3 reviews)

39

students

2 hours

content

Jun 2022

last update

$19.99

regular price

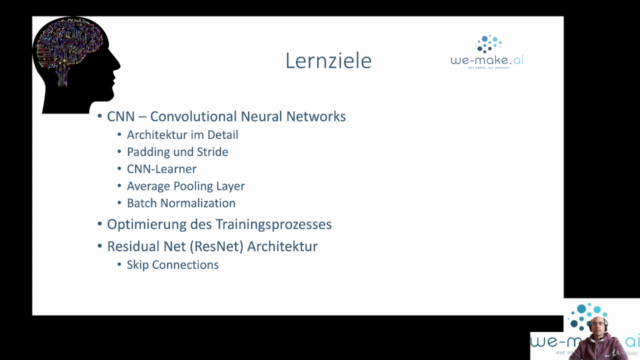

What you will learn

Du kennst Convolutional Neural Networks. Nun lernst du, wie diese Layer aufgebaut sind und funktioneren!

Wir bauen gemeinsam einen Convolutional Filter theoretisch und praktisch auf.

Wozu dienen Paddings und Strides in einer Convolution?

Wie ist eine Convolution im fastai Framework durch den CNN-Learner umgesetzt?

Welche Techniken zur Optimierung eines CNNs sind in der Trainingsmethode des fastai Frameworks gekapselt?

Wozu brauche ich einen Batch-Normalization Layer?

Was ist ein Residual Block und wie wird daraus ein Residual Net (ResNet)

Was bedeutet Average Pooling (im Unterschied zu MaxPooling)? Wie implementiere ich einen Average Pooling Layer?

Was sind Skip-Connections? Welche Bedeutet haben Skip-Connections in der ResNet Architektur und wie kann ich diese implementieren?

Screenshots

Related Topics

3819504

udemy ID

2/2/2021

course created date

2/5/2021

course indexed date

Bot

course submited by